https://arxiv.org/pdf/2401.18059

트리 구조를 만들어 하위 노드의 구체적인 내용을 요약해서 상위 노드를 만들어 가는 컨텍스트로서 재귀적 요약을 수행한다.

즉, 하위 레이어의 청크를 요약해서 클러스터를 만들고, 클러스터의 내용을 요약해서 상위 레이어의 요약본을 만드는 방식

RAPTOR는 긴 문서에서 정보를 효율적으로 추출하기 위해 재귀적인 요약 및 클러스터링을 통해 계층적 트리 구조를 생성합니다. 기존 방식이 짧은 텍스트 조각만 검색하여 전체적인 맥락 이해에 한계가 있었던 반면, RAPTOR는 다양한 추상화 수준에서 정보를 통합합니다. 연구는 RAPTOR가 질의응답(QA) 작업에서 기존 검색 방식보다 우수합니다. 이 시스템은 확장성과 계산 효율성이 뛰어나 방대한 텍스트 코퍼스 처리에도 적합합니다.

- 논문에서는 일반적으로 100토큰 이하로 매우 작게 자릅니다.

- 먼저 클러스터링 알고리즘을 통해 주제나 의미가 비슷한 것끼리 묶습니다. 이떄 하나의 청크가 여러 클러스터에 동시에 포함될 수 있습니다.

- 각 클러스터에 속한 청크들을 임베딩한 뒤 LLM을 사용해 요약을 수행합니다. 이 요약본이 새로운 노드로 만들어져 상위 레이어를 구성합니다. 상위로 올라갈수록 내용은 더 추상화되고 요약된 형태가 됩니다.

- 노드에는 Index(노드 번호), 하위 노드의 번호, 요약본, 임베딩 벡터와 같은 정보가 포함되어 있습니다. 따라서 각 노드가 어떤 청크들로부터 만들어졌는지 알 수 있고, 요약된 내용을 임베딩으로 변환해 나중에 검색 시 활용할 수 있습니다.

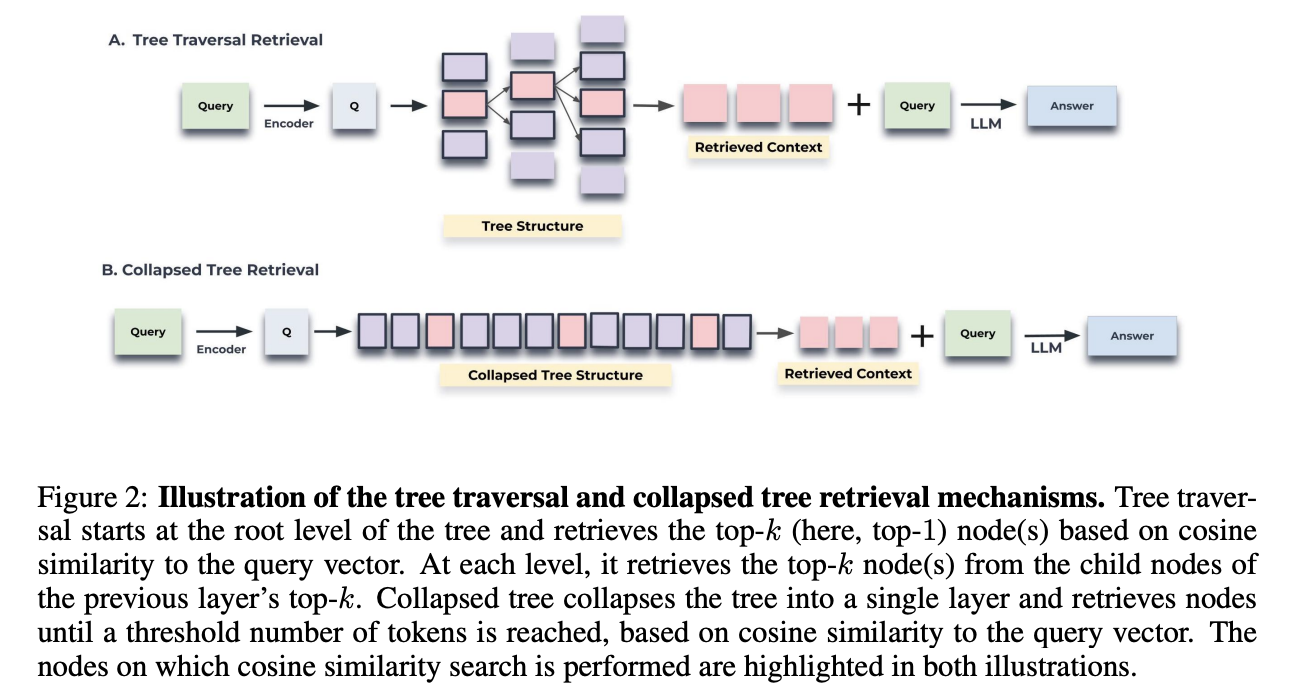

- 트리 탐색 검색 (A): 이 방법은 쿼리 벡터와의 코사인 유사도를 기반으로 트리의 루트 레벨부터 시작하여 최상위 k개의 노드를 검색합니다. 그 다음, 이전 레이어에서 선택된 노드들의 자식 노드 중에서 다시 최상위 k개의 노드를 검색하는 과정을 재귀적으로 반복하여 하위 레이어로 내려갑니다. 이 방식을 통해 검색되는 정보의 특이성과 범위를 제어할 수 있습니다.

- 축소 트리 검색 (B): 이 방법은 더 간단하게 관련 정보를 검색합니다. 다층 트리를 단일 레이어로 '축소'하여 모든 노드를 동일한 레벨로 가져옵니다. 즉, 계층 구조를 없애고 모든 노드를 동등한 레벨로 가져옵니다. 그 후, 쿼리 임베딩과의 코사인 유사도 점수가 가장 높은 최상위 k개의 노드를 선택하며, 미리 정의된 최대 토큰 수에 도달할 때까지 노드를 계속 추가합니다. 이 그림에서는 코사인 유사도 검색이 수행되는 노드들이 강조되어 있습니다. 소스에 따르면 축소 트리 접근 방식이 트리 탐색보다 더 나은 성능을 보였습니다.

- RAPTOR가 정보 검색을 위해 어떻게 트리 구조를 활용하는지, 그리고 이를 Dense Passage Retrieval (DPR)과 비교하여 보여줍니다. 특히, "신데렐라는 어떻게 행복한 결말을 찾았는가?"와 "이야기의 중심 주제는 무엇인가?"와 같이 신데렐라 동화에 대한 두 가지 질문에 대해 RAPTOR가 정보를 검색하는 방식을 예시로 들어 설명합니다.

- 그림에서 강조된 노드는 RAPTOR가 선택한 노드를 나타내고, 화살표는 DPR이 선택한 리프 노드를 가리킵니다.

- RAPTOR가 질문의 상세 수준에 맞춰 다른 트리 레이어에서 노드를 선택할 수 있다는 점을 보여줍니다. 또한, DPR에 의해 검색된 정보가 RAPTOR가 검색한 컨텍스트에 직접 리프 노드로 포함되거나 더 높은 레이어의 요약으로 간접적으로 포함되는 경우가 많다는 것을 시사합니다.

- 이는 RAPTOR의 트리 구조가 더 관련성 있고 포괄적인 정보를 제공하여 다운스트림 작업에서 더 나은 성능을 가능하게 함을 보여주기 위함입니다.

728x90

반응형

'NLP | LLM' 카테고리의 다른 글

| LLM 보안 (Prompt Injection, LLM Firewall, AI Security Mesh) (1) | 2025.09.04 |

|---|---|

| LangSmith을 활용해 RAG 평가하기 (0) | 2025.08.21 |

| 문서 요약하기 (LLM) (0) | 2025.08.20 |

| 오픈소스로 Reasonging RAG 구축하기 (6) | 2025.07.23 |

| A2A (Agent-to-Agent): 지능형 에이전트 협업 (3) | 2025.07.22 |