1. 오차역전파란?

역전파는 계산 결과와 정답의 오차를 구해서 이 오차에 관여하는 노드 값들의 가중치와 편향을 수정하는데, 이때 오차역전파(backpropagation)는 오차가 작아지는 방향으로 반복해서 수정합니다. 이 횟수가 커지면 그만큼 정확성은 높아지지만 시간이 오래 걸리는 단점이 있고, 횟수가 작아지면 정확성은 떨어지지만 시간이 단축되는 장점이 있습니다. 이 횟수의 주기를 1 에포크(epoch)라고 하며, 에포크를 늘리면서 가중치와 편향을 업데이트(학습)하여 점점 오차를 줄여 나갑니다.

2. 계산방식

(1) 입력 값에 가중치를 곱한 값과 편향을 합하여 그 값이 임계치인 0을 넘으면 1을 출력하고, 그렇지 않으면 0을 출력하는 순전파 과정을 거친다.

(2) 출력 값과 정답의 차이인 오차를 구한다. 역방향으로 오차를 줄이는 가중치 값으로 수정.

(3) 출력층의 가중치 값을 수정.

(4) 은닉층의 가중치 값을 수정.

3. 가중치 사용할 때

편미분을 사용하는 이유는 수많은 노드에 부여되는 모든 가중치 값을 고려할 필요 없이 연결된 가중치만 고려하면 되기 때문입니다. 또 연쇄 법칙을 이용하면 출력층과 입력층 사이에 은닉층이 많아도 간단한 미분으로 기울기를 계산할 수 있기 때문입니다.

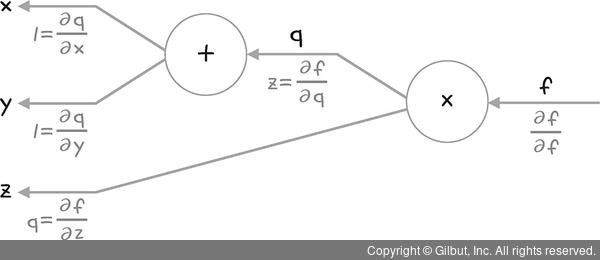

4. 덧셈의 역전파

입력된 값 그대로 다음 노드로 전파

5. 곱셈의 역전파

상류(출력)값 (1에서 시작)에 순전파의 입력 신호를 '서로 바꾼 값'을 곱해서 하류(은닉층)으로 보냄

Last Updated. 2025.06.18

🔖 참고 자료

728x90

반응형

'ML | DL' 카테고리의 다른 글

| [인공지능 기초수학] #3. 벡터 with 인공지능, 파이썬 (4) | 2025.06.18 |

|---|---|

| [인공지능 기초수학] #2. 스칼라, 벡터, 행렬, 텐서 (0) | 2025.06.18 |

| 머신러닝과 딥러닝 개념 총정리 (2) | 2025.06.17 |

| How does data sparsity affect your models? (0) | 2023.02.03 |

| [Interpolation] Interpolation (python) (0) | 2022.11.15 |